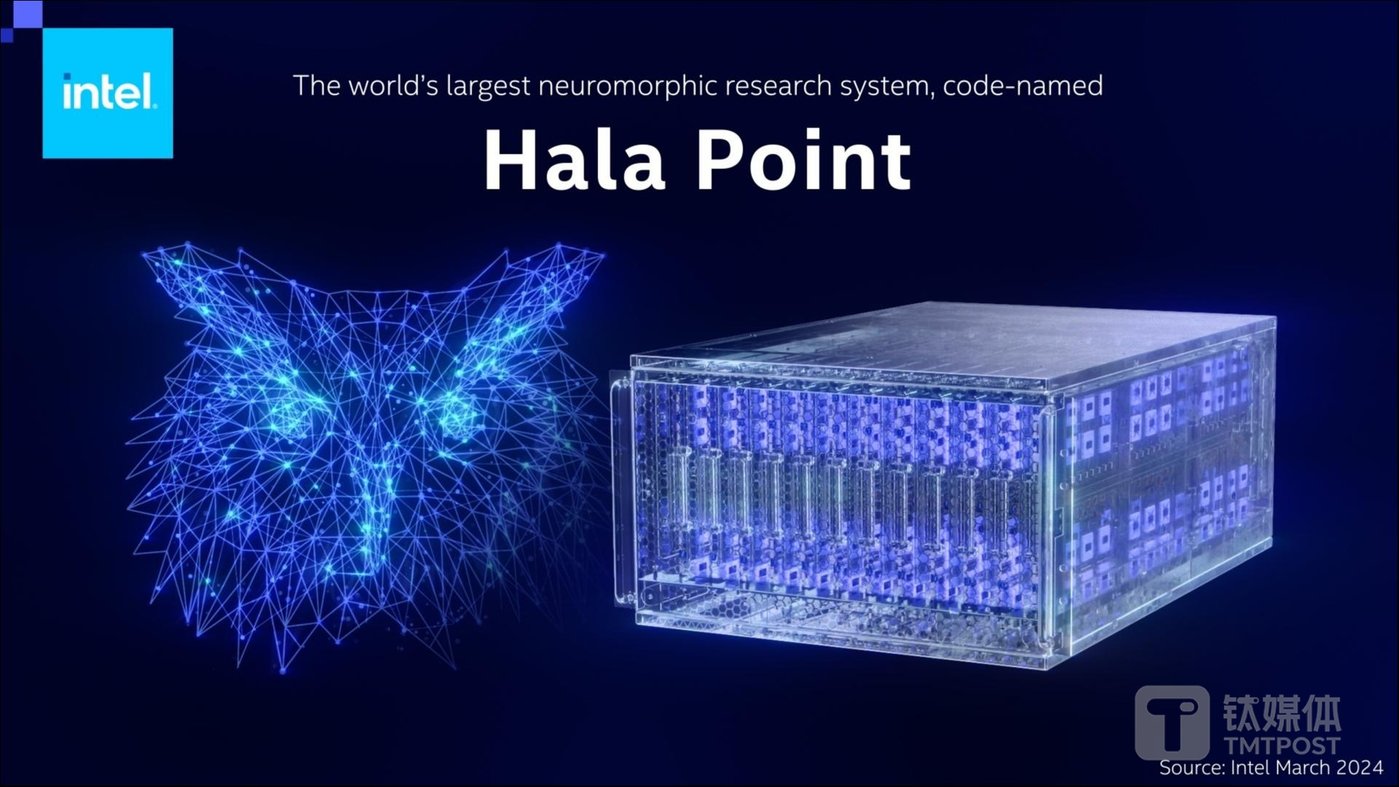

Hala Point 系统集群(图片来源:英特尔)

人工智能(AI)领域迎来重大事件。

北京时间 4 月 18 日凌晨,美国芯片巨头英特尔(Intel)宣布,其打造出全球最大的神经拟态系统——Hala Point,旨在支持未来类脑 AI 研究,以及解决 AI 目前在效率和可持续性等方面的挑战。

Hala Point 内置 1152 个、基于 Intel 4(7nm)制程的英特尔 Loihi 2 处理器,支持多达 11.5 亿个神经元和 1280 亿个突触,每秒可处理超过 380 万亿个 8 位突触和超过 240 万亿个神经元操作,相关系统最初部署在美国桑迪亚国家实验室。应用于仿生尖峰神经网络模型时,在运行神经元数量较低的情况下,Hala Point 速度可比人脑快 200 倍(20000%)。

英特尔研究院神经拟态计算实验室总监 Mike Davies 表示:“目前,AI 模型的算力成本正在以不可持续的速度上升。行业需要能够规模化的全新计算方法。为此,英特尔开发了 Hala Point,将高效率的深度学习和新颖的类脑持续学习、优化能力结合起来。我们希望使用 Hala Point 的研究能够在大规模 AI 技术的效率和适应性上取得突破。”

事实上,所谓神经拟态芯片,是一种模拟生物神经元的芯片。

与普通芯片不同的是,神经拟态芯片的计算任务是由许多小单元进行的,单元之间通过类似生物神经的尖峰信号相互通信,并通过尖峰调整其行为。

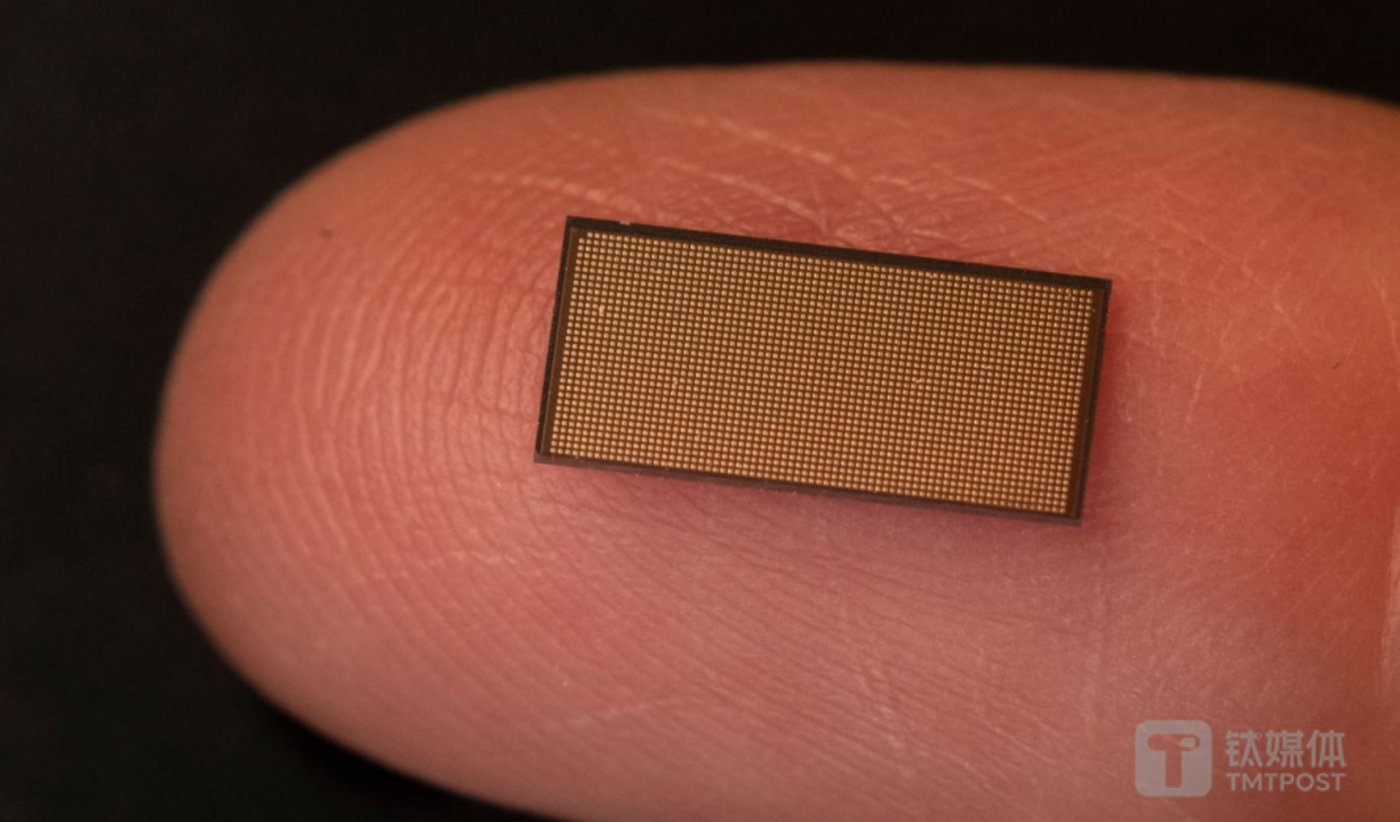

早在 2018 年,基于英特尔研究院的先进技术研究,英特尔推出了首款神经拟态芯片 Loihi,采用 14nm 制程,可应用于机器嗅觉等场景。

2021 年,Loihi 系列全面升级,英特尔发布了第二代神经拟态芯片 Loihi 2,采用英特尔第一个 EUV 工艺节点 Intel 4,芯片等效于 4nm,实际为 7nm 工艺。

Loihi 2 共有 128 个神经拟态核心,这 128 个内核每一个都有 192KB 的灵活内存,每个神经元可以根据模型分配多达 4096 个状态,而之前的限制只有 24 个。

与普通的 CPU 和 GPU 不同,神经拟态没有外部内存。每个神经元都有一小部分内存供其专用。主要作用是分配给不同神经元输入的权重、最近活动的缓存以及峰值发送到的所有其他神经元的列表。Loihi 2 可以根据用途选择各种不同连接选项,这一点上有些类似于 FPGA。

英特尔强调,在执行 AI 推理负载和处理优化问题时,Loihi 2 神经拟态芯片系统的速度比常规 CPU 和 GPU 架构快 50 倍,同时能耗降低 100 倍。

除了硬件产品外,英特尔还发布了用于 Loihi 芯片的软件,一个名为 Lava 的新开发框架。该框架以及相关库都用 Python 编写,并在 GitHub 上开源,开发人员无需访问硬件即可为 Loihi 开发程序。

如今,英特尔已经将 Loihi 2 芯片用于机械臂、神经拟态皮肤、机器嗅觉等场景。英特尔表示,Loihi 2 应用了众多类脑计算原理,如异步(asynchronous)、基于事件的脉冲神经网络(SNNs)、存算一体,以及不断变化的稀疏连接,以实现能效比和性能的数量级提升。神经元之间能够直接通信,而非通过内存通信,因此能降低整体功耗。

英特尔 Hala Point 神经拟态系统研究团队

而在新一轮 AI 技术引领下,4 月 17 日,英特尔将这个神经拟态芯片进行“暴力组装”,构建了全球最大的神经拟态系统 Hala Point 。

具体来说,Hala Point 系统由封装在一个六机架的数据中心机箱中的 1152 个 Loihi 2 处理器(采用 Intel 4 制程节点)组成,大小相当于一个微波炉。该系统支持分布在 140544 个神经形态处理内核上的多达 11.5 亿个神经元和 1280 亿个突触,最大功耗仅为 2600 瓦。Hala Point 还包括 2300 多个嵌入式 x86 处理器,用于辅助计算。

Hala Point 将处理、内存和通信通道集成在大规模并行结构中,提供总共 16 PB/s 的内存带宽、3.5 PB/s 的内核间通信带宽和 5 TB/s 的带宽(TB/s)的芯片间通信带宽。该系统每秒可以处理超过 380 万亿个 8 位突触和超过 240 万亿个神经元操作。

在用于仿生脉冲神经网络模型时,Hala Point 能够以比人脑快 20 倍的实时速度运行其全部 11.5 亿个神经元,在运行神经元数量较低的情况下,速度可比人脑快 200 倍。虽然 Hala Point 并非用于神经科学建模,但其神经元容量大致相当于猫头鹰的大脑或卷尾猴的大脑皮层。

早期研究结果表明,通过利用稀疏性高达 10 比 1 的稀疏连接(sparse connectivity)和事件驱动的活动,Hala Point 运行深度神经网络的能效比高达 15 TOPS/W,同时无需对输入数据进行批处理。批处理是一种常用于 GPU 的优化方法,会大幅增加实时数据(如来自摄像头的视频)处理的延迟。尽管仍处于研究阶段,但未来的神经拟态大语言模型将不再需要定期在不断增长的数据集上再训练,从而节约数千兆瓦时的能源。

英特尔表示,Hala Point 在其前身 Pohoiki Springs 的基础上实现了大幅提升,基于神经拟态计算技术提升了主流、常规深度学习模型的性能和效率,尤其是那些用于处理视频、语音和无线通信等实时工作负载的模型。其架构经过改进,神经元容量提高了 10 倍以上,性能提高了 12 倍。

目前,Hala Point 是一个旨在改进未来商用系统的研究原型。英特尔预计其研究将带来实际技术突破,如让大语言模型拥有从新数据中持续学习的能力,从而有望在 AI 广泛部署的过程中,大幅降低训练能耗,提高可持续性。

英特尔透露,接下来,Hala Point 系统将向桑迪亚国家实验室交付,从而标志着英特尔共享的大型神经拟态研究系统的首次部署,进一步推动神经拟态计算应用和类脑 AI 研究等。如今,英特尔神经拟态研究社区(INRC)成员总数已超过 200 个。

不过,英特尔这套神经拟态技术在深度学习领域仍面临一定的质疑。

Meta 首席科学家、图灵奖得主 Yann LeCun 曾在 2019 年的一次会议上驳斥了神经拟态计算方法。他认为,神经形态方法没有取得实际成果,像 ResNet 等深神经网络已经在计算机视觉上取得了巨大的成功。

不过,IBM 于 2014 年推出了 TrueNorth 芯片,尽管其运行频率只有几 kHz,但它所模拟大脑尖峰神经网络所需的计算资源,只传统处理器 0.0001%。Mike Davies 曾表示,Loihi 在某些特定工作负载上,可以比传统处理器效率高出 2000 倍。

新的 AI 时代已经到来,Hala Point 或将成为未来英特尔打开 AGI 时代的重要一把“钥匙”。

(本文首发于钛媒体 App,作者|林志佳,编辑|胡润峰)