人工智能时代的能耗黑洞

据估算,到 2027 年,人工智能行业每年将消耗 85~134 太瓦时的电力,相当于瑞典或荷兰一年的总用电量。

马斯克判断,电力缺口最早可能会在 2025 年发生,“明年你会看到,我们没有足够电力来运行所有的芯片”。

黄仁勋也担忧电能供给,但给出了一个更乐观的展望:过去 10 年,计算和人工智能提高了 100 万倍,而它消耗的成本、空间或能源并未增长 100 万倍。

作者丨魏琳华

来源丨雪豹财经社

3 月底,美国密歇根湖畔的一座已经关闭的核电站 Holtec Palisades,获得来自美国能源部的 15 亿美元贷款担保,进入重启阶段。如果顺利通过监管环节,它将成为美国历史上第一座重启的核电站。

美国能源部之所以重启核电发力,是出于对电能需求失衡的担忧。在制造业、电动汽车等行业的耗电需求上升之际,人工智能行业的快速发展,加速了美国电力危机的到来。

“人工智能本身不是问题,因为它可以帮助解决问题。”美国能源部长詹妮弗·格兰霍姆在接受 Axiro 采访时表示,但是,人工智能和数据中心对电力日益增长的需求,却成了实实在在的新问题。

小小应用,吃电狂魔

人工智能应用究竟有多耗电?

荷兰科学家亚历克斯·德弗里斯在他的论文中,为对话机器人 ChatGPT 算了这样一笔账:

每当 ChatGPT 试图响应一次问题,它需要消耗 2.9 瓦时的电量。这是什么概念?响应 10 次的电量,可以支撑一个功率 15W 的 LED 灯泡工作 2 小时;响应 100 次,可以给智能手机充大约 13 次电。

一天内,ChatGPT 平均需要处理约 2 亿个来自用户的对话请求,这意味着它单日消耗的电量就要超过 564 兆瓦时(1 兆瓦时=1000 千瓦时,564 兆瓦时相当于 56.4 万度电)。以美国每个家庭每日平均耗电量换算,ChatGPT 每天需要消耗掉 1.7 万个美国家庭一天的用电量。

由于模型参数、能耗处理等因素差异,不同 AI 模型的耗电量无法被准确估算。于是,亚里克斯以英伟达推出的 A100 服务器作为测算对象,对整个人工智能行业可能产生的耗电量进行估算。

基于他的假设,到 2027 年,英伟达可能推出 150 万台 A100 服务器,其中 95% 将被应用于 AI 行业。每一台 DGX A100 型号的服务器内置 8 张 A100 芯片,以 1140 万张 A100 芯片的耗电量进行估算,2027 年,整个人工智能行业每年的耗电量将高达 85~134 太瓦时(1 太瓦时=1×10⁶千瓦时)。

也就是说,到 2027 年,AI 耗电量或将接近人口超过 1000 万的瑞典或 1700 万人口的荷兰一年的总用电量,相当于当前全球用电量的 0.5%。

按照这个估算值,AI 的耗电量或将比肩比特币挖矿。据剑桥大学计算,比特币挖矿一年耗电量大约是 165.99 太瓦时,接近人口一亿的埃及一年的用电量。

比特币挖矿如此耗电,是由它的工作方式决定。在比特币之父中本聪的设计中,比特币系统通过工作量证明(Proof-of-Work)的方式,让矿工们竞相计算出一个足够困难的哈希值(由数字+字母构成的字符串)来创建新的区块并获取奖励。这种竞争性的计算过程,需要消耗大量的电力和计算能力。

AI 之所以如此能吃电,是因为大模型的训练和推理过程均需消耗大量电力。

大模型质量的关键在于数据、算力和顶尖人才,而高算力的背后,是靠着数万张芯片昼夜不停的运转支撑。

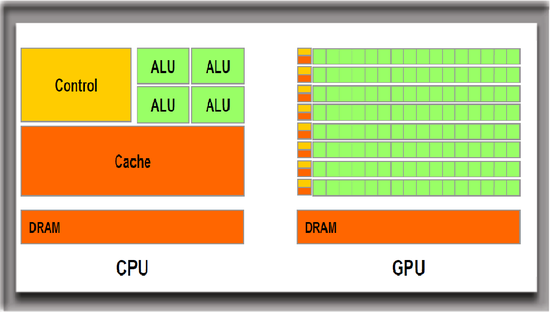

相比于平常安装在笔记本电脑上的 CPU(中央处理器),GPU(图形处理器)被证明是更适合 AI 训练的硬件。如果把 CPU 看做一个处理单任务的元件,那么 GPU 的优势就是同时处理多个并发任务。虽然 GPU 起初并非为了处理 AI 需求而生,但同时处理多任务的特质,让它成为进入 AI 大模型训练场的门票。

和 CPU 相比,GPU 可以处理多个并行任务,图源:英伟达官网

快的代价是更高的能量损耗。据估算,一张 GPU 比 CPU 的能耗高出 10~15 倍。在大模型训练过程中,需要多张 GPU 接连不断运转。大模型参数量和数据量越大,训练耗费的电量也越大。

以 GPT-3 的训练为例,斯坦福人工智能研究所发布的《2023 年人工智能指数报告》显示,1750 亿参数的 GPT-3 在训练阶段的耗电量高达 1287 兆瓦时。哈工大人工智能研究院院长刘劼打了个比方,相当于开车从地球到月球往返一次。

在完成训练后,AI 在推理方面的耗电量又远超过训练耗费的电量。

每响应一个请求,大模型需要完成推理过程,找到最接近问题的解答。按照上述数据推算,GPT-3 在训练阶段消耗的电量,甚至无法支撑 ChatGPT 运行 3 天。

在多模态大模型发展成为主流的情况下,在 AI 响应需求的推理过程中,耗电量还将进一步提升。据人工智能公司 Hugging Face 的研究,不仅多模态大模型耗电量远超过一般模型,涉及图像处理的模型也比纯文本处理更耗电。

具体到不同任务,文本分类、标记和问答等简单任务相对低耗,千次推理仅需 0.002~0.007 千瓦时。而在响应多模态任务时,一次文本到图像生成耗能最高需要用到 2.9 千瓦时,相当于 ChatGPT 响应 100 次的耗电量。

巨头的 AI 梦,把电力缺口撕得更大

从训练 15 亿参数的 GPT-2 到训练 1750 亿参数的 GPT-3,Open AI 从十亿参数到千亿参数的跨越,仅用了一年时间。

大模型狂飙之际,越来越多的大型科技公司开始把 AI 和公司主营业务的融合提上日程。

谷歌试图在搜索中结合 AI 功能,但它的能耗十分惊人。去年 2 月,谷歌母公司 Alphabet 董事长 John Hennessy 表示,在搜索中应用人工智能的成本将是普通搜索的 10 倍。

前述斯坦福人工智能研究所发布的《2023 年人工智能指数报告》认为,每次 AI 搜索的耗电量大约为 8.9 瓦时,对比谷歌单次搜索 0.3 瓦时的耗电量,加入 AI 的单次耗电量几乎是一般搜索耗电量的 30 倍。

和 Open AI 合作密切的微软,也计划把 AI 大力“塞进”它的几个主要产品线,如 Office 软件、Windows 操作系统、Bing 搜索引擎、Azure 云服务等。

为了提供更充足的算力,以支撑 AI 大模型的训练和使用,作为底座的基础设施——数据中心的建造已被科技企业们纳入下一步规划。

2023 年,谷歌斥资超 25 亿美元,分别在俄亥俄州、爱荷华州、亚利桑那州梅萨建造数据中心。看好 AI 发展的亚马逊计划在未来 15 年中投入 1500 亿美元兴建数据中心。

当膨胀的电量需求无法被一一满足,美国部分城市的电力拉响了告急的警报。

美国拥有全球最多的数据中心。截至 2022 年,美国有超 2300 个数据中心,占全球数据中心的1/3。

其中,包括亚马逊、微软、谷歌等在内的云计算巨头在美国本土的数据中心布局尤为庞大。据 Synergy Research Group 统计,在超大规模运营商当中,亚马逊、微软和谷歌合计占据所有主要数据中心的一半以上。微软在美国拥有 24 个可用区,一个可用区配备 3 个或以上数据中心。

据国际能源署(IEA)预测,未来几年,美国数据中心用电量将快速增长。IEA 警告,2022 年,美国数据中心的用电量已占美国总电力的4% 以上,到 2026 年,其用电量占比将提升至6%,此后几年还将持续扩大。

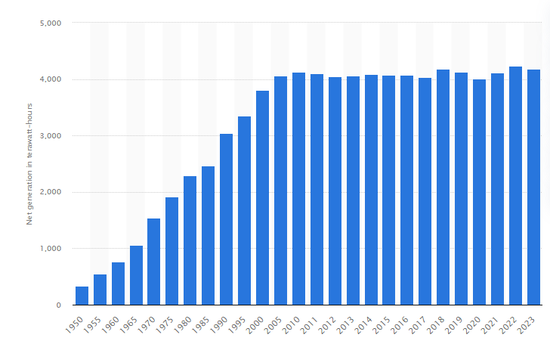

但是,与快速增长的人工智能电力需求相悖的是,美国的发电量并没有出现明显增长的迹象。

据美国能源信息署,2023 年,美国全口径净发电量为 41781.71 亿千瓦时,比上一年下降 1.2%。实际上,近十年来,美国的全年净发电量一直在 40000 亿千瓦时的边缘徘徊。

1950-2023 年美国净发电量变化(单位:十亿千瓦时)图源:Statista

造成美国缺电的元凶之一是其脆弱的电网输送设施。美国的变压器、输电线路等电网基础设施建于上世纪 60 年代至 80 年代,电路老化问题明显。白宫在 2022 年的一份文件中指出,许多变压器和输电线路正接近或已超过其设计寿命,全国 70% 的输电线路已经使用了 25 年以上。

在老化的电网基础设施之下,美国从其他地区输电和接入可清洁能源扩充电网储备能量的想法均无法实现。美国能源部(DOE)发布的一份报告指出,在德克萨斯州、阿拉斯加州等多个地区,美国建成的输电系统已面临满负荷的情况。

为了加强美国各州电网的弹性和可靠性,去年,美国能源部宣布,将对 44 个州的 58 个项目投资 34.6 亿美元。

电力危机已近在眼前。在不久的将来,它还可能成为制约 AI 发展的关键因素。

2024 年 2 月,在达沃斯世界经济论坛上,Open AI 首席执行官萨姆·阿尔特曼提到了 AI 带来的电力危机。在他看来,人工智能消耗的电力将远远超出人们的预期。“我们尚未充分认识到 AI 的能源需求。如果没有重大突破,我们就无法实现(通往 AGI)这一目标。”

在博世互联网论坛上,特斯拉 CEO 马斯克同样强调了人工智能面临的发展困境。“接下来短缺的将是电力。”他判断,电力缺口最早可能会在 2025 年发生。“明年你会看到,我们没有足够的电力来运行所有的芯片。”

钳制与出路

不堪重负的电网已经开始限制科技企业的业务拓展。

在社交媒体X上,开源社区 OpenPipe 创始人 Kyle Corbitt 分享了他和微软工程师的对话,他们提到了 Open AI 在训练 GPT-6 期间,GPU 在不同州之间面临的传输困境。

“我们不可能在一个州投放超过 10 万个 H100 芯片,同时还不破坏电网。”一张 H100 的最大功耗为 700 瓦,根据微软工程师的测算,以年利用率 61% 来算,10 万张 H100 的耗电量将高达 42 兆瓦时。

为了满足飙升的电力需求,首先被牺牲的是减少碳排放的目标。

据《华盛顿邮报》,美国多地电力需求增长超出预期。以佐治亚州为例,预计未来十年的新增用电量将是最近的 17 倍。位于美国堪萨斯州、内布拉斯加州、威斯康星州和南卡罗来纳州的燃煤电厂已经决定延迟退休时间。

面对吃电大户挖矿机,不同国家推出了程度不同的监管政策。据美国能源部估计,加密货币挖矿的年用电量或占美国用电量的 0.6% 至 2.3%。为此,美国考虑对加密货币挖矿业务征收高达 30% 的数字资产采矿能源消费税。加拿大已有三个省份宣布加密货币挖矿禁令。

AI 也引起了监管机构的关注。由于每家 AI 企业的能源损耗情况难以被统一量化估计。海外监管机构开始推动立法,要求人工智能开发企业披露能源的使用情况,以合理估算 AI 带来的能耗影响。

今年 3 月,欧盟 27 个成员国批准通过的《人工智能法案》中,要求“高风险人工智能系统”报告其能源消耗和资源使用情况。

科技企业的掌舵者几年前就押注新型能源公司,期待用清洁的可再生能源支撑庞大的电力需求。

2021 年,Open AI 首席执行官阿尔特曼向核聚变初创公司 Helion Energy 投入 3.75 亿美元。2023 年 5 月,微软与这家公司签署购电协议,预定从 2028 年开始向其购买 50 兆瓦电力。坏消息是,它甚至不足以支撑 GPT-3 训练耗费电量的1/25。

通过技术优化性能,也能显著降低能耗。

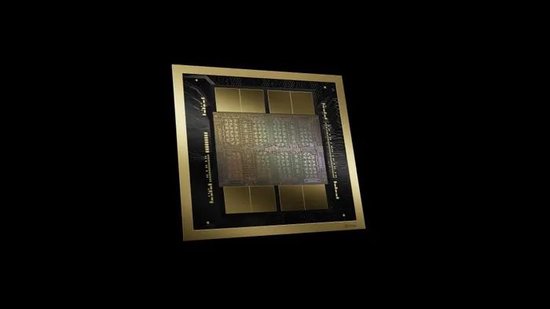

在今年的 GTC 发布会上,英伟达 CEO 黄仁勋带来了一款新的 GPU 产品 Blackwell。通过使用新的架构,它的能耗降低了 70% 以上:训练一个 1.8 万亿参数的 GPT 模型,传统方法可能需要 8000 个 GPU、15 兆瓦,历时 90 天。而 Blackwell 只需 2000 个 GPU,功耗 4 兆瓦。

相比马斯克和阿尔特曼的警世之言,黄仁勋也同样担忧电能的供给,但他给出了一个更加乐观的展望:“过去十年,我们将计算和人工智能提高了 100 万倍……而它所消耗的成本、空间或能源,并未增长 100 万倍。”

英伟达在 2024GTC 大会上发布的 BlackWell,图源:英伟达官网

写在最后

一个多世纪之前,能源革命改变了人们的生活方式。从燃烧麦草的火力过渡到煤炭、石油,在历史发展的关键时期,人们对新能源的挖掘推动了工业革命的进程。

“每一个煤筐里都装着动力与文明。”美国思想家、文学家爱默生曾如是感慨。

一种能源的稀缺,往往成为挖掘新一种能源的动力。在《黑石头的爱与恨:煤的故事》一书中,作者巴巴拉·弗里兹讲述了发生在 16 世纪英国的“木材危机”。

“由于城市的不断扩大,附近郡县的森林渐渐被砍伐殆尽,人们不得不从越来越远的地方运来木材.……单是伦敦的酿酒者,每年就要烧掉两万货车的木头。”当木头价格的上涨超过通货膨胀的速度,成为稀缺资源后,英国国内的用煤量剧增。

能源的开采和使用,成为决定工业发展的关键之手。充足的煤炭支撑英国发展纺织业、钢铁业,成为第一次工业革命的中心,而石油的开采则带动汽车、飞机等行业的兴旺。

在化石能源枯竭的危机下,对新能源的利用,不仅能缓解迫近人工智能行业的能源危机,也承载着人类科技继续前行的“动力与文明”。

参考资料

[1] Granholm eyes talks with Big Tech on AI power needs.Axios

[2] Amid explosive demand, America is running out of power.The Washington Post

[3] Nvidia CEO Jensen Huang at World Government Summit.

[4] The AI Act Explorer.

[5] Bitcoin: A Peer-to-Peer Electronic Cash System.Satoshi Nakamoto

[6] A.I. Could Soon Need as Much Electricity as an Entire Country.The New York Times

[7] Cambridge Blockchain Network Sustainability Index: CBECI.CCAF

[8] The Biden-Harris Administration Advances Transmission Buildout to Deliver Affordable, Clean Electricity.The White House

[9] Microsoft, Amazon and Google Account for Over Half of Today’s 600 Hyperscale Data Centers.Synergy Research Group