新智元报道

编辑:编辑部

GPT-5 还未发布,GPT-6 已经在路上了?微软工程师曝出,为 GPT-6 搭建 10 万个 H100 训练集群,整个电网却被搞崩。通往 AGI 大关,还需要破解电力难题。

GPT-6 也被电力卡脖子了——部署十万个 H100 时,整个电网发生了崩溃!

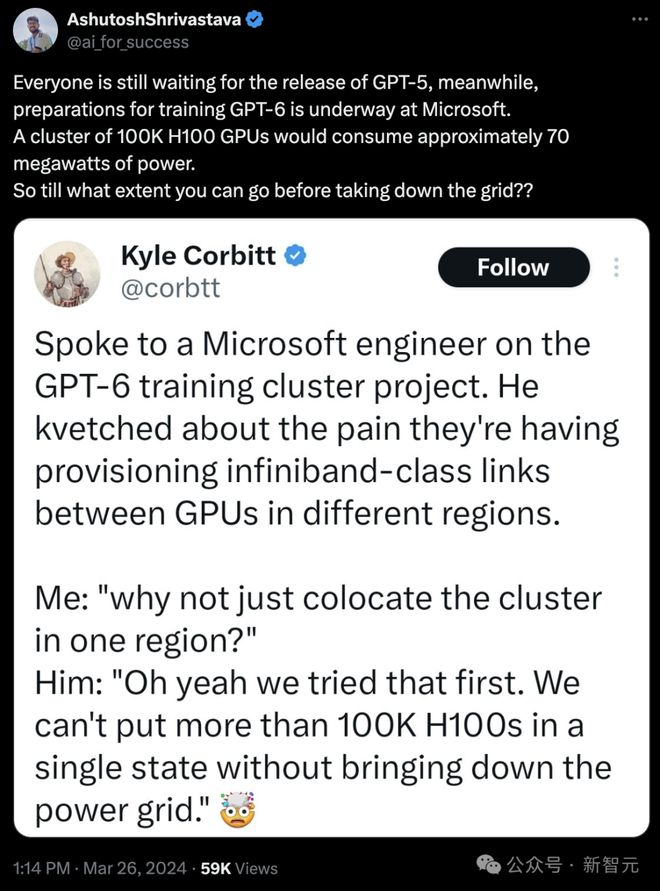

就在刚刚,微软工程师爆料,10 万个 H100 基建正在紧锣密鼓地建设中,目的就是训练 GPT-6。

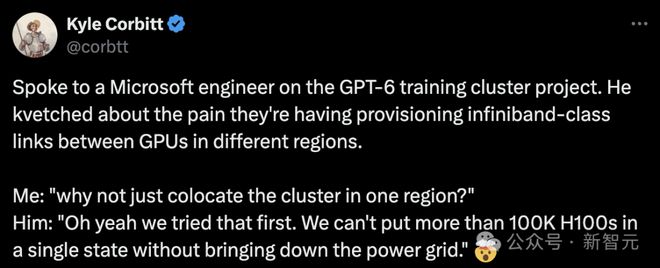

微软工程师吐槽说,团队在部署跨区域 GPU 间的 infiniband 级别链接时遇到了困难。

Corbitt:为何不考虑直接将所有设备部署在同一个地区呢? 微软工程师:这确实是我们最初的方案。但问题是,一旦我们在同一个州部署超过 100,000 个 H100 GPU,电网就会因无法负荷而崩溃。

这是创业者 Kyle Corbitt 在社交媒体上,分享自己与一位微软工程师关于 GPT-6 训练集群项目的对话

没想到,GPT-5 还没发,微软就已悄悄为 OpenAI 开始训练 GPT-6 了。

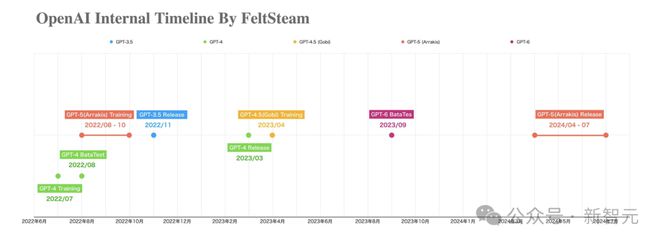

同在今天,一张「OpenAI 内部时间线」图片在网上疯转。

图中清晰标注出:OpenAI 早在 2022 年 8 月-10 月之间开始了 GPT-5(代号 Arrakis)的训练,2023 年 4 月 GPT-4.5(代号 Gobi)在训练中。

并且图中显示,GPT-6 的测试,预计早在去年 9 月就开始了!

同时,关于 GPT-5(Arrakis)的一个爆料帖,也随之浮出水面。

太长不看版

贴中爆出许多内幕消息。

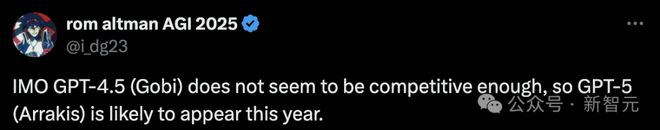

比如,GPT-4.5 因为能力不够,干脆被跳过,所以今年 OpenAI 会直接发 GPT-5。

另外还有若干未经证实的消息(从上图中也可以看出),关于 OpenAI 手中握着的一大把模型——

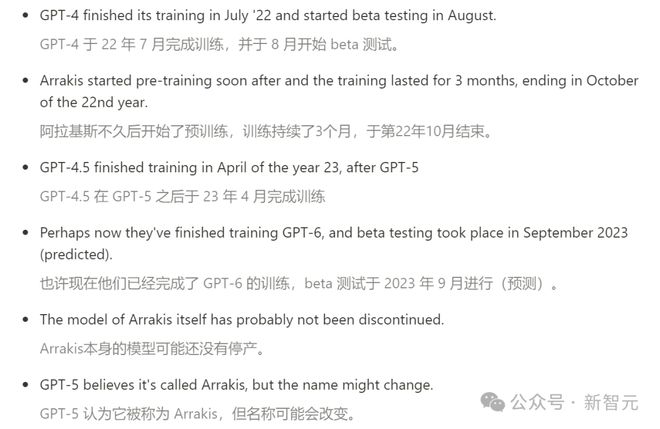

比如,Arrakis/GPT-5 在 GPT-4 不久后训练了 3 个月,于 22 年 10 月结束;在 GPT-5 之后,GPT-4.5 于 23 年 4 月完成训练。

最劲爆的消息当然就是,现在 GPT-6 或许已经在训练中了。

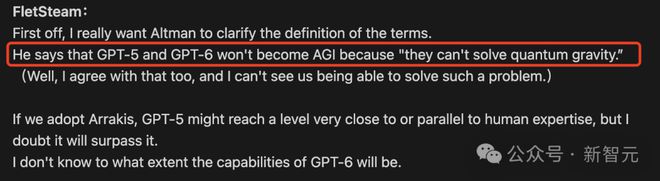

但是,GPT-5 并不是 AGI,因为无法解决「量子引力」问题。同理,GPT-6 也不是 AGI。

接下来,让我们一一盘点下,帖子中都有哪些信息点。

最接近 AGI 的模型,与人类专家不相上下

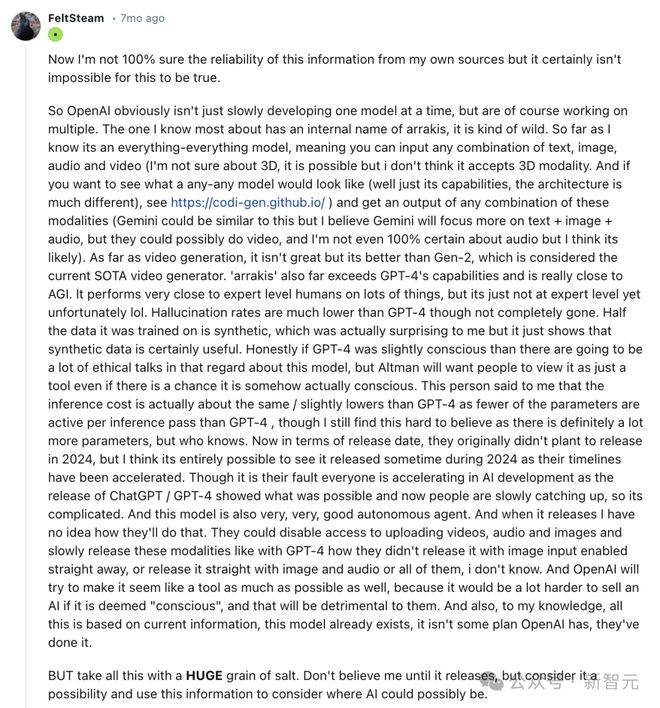

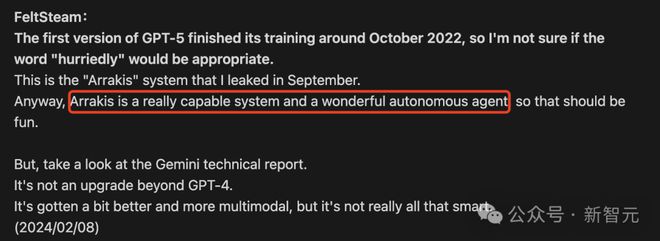

去年 8 月,FeltSteam 最先曝出 OpenAI 内部正在进行一个 Arrakis 多模态模型的项目,远超 GPT-4,非常接近 AGI。

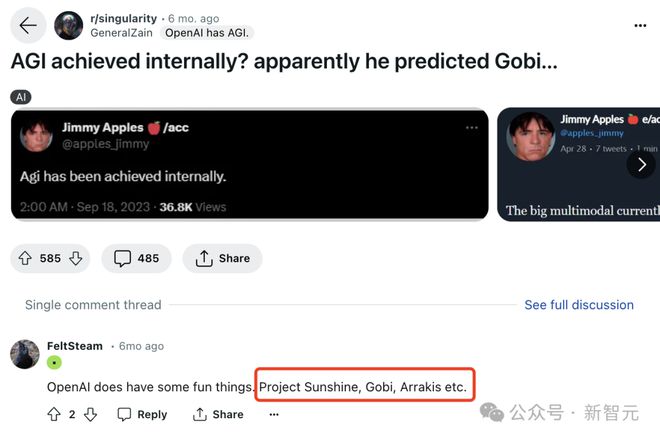

Arrakis 项目被首次提及,是名叫 FeltSteam 的网友最先在 Reddit 一个评论区中爆料称,「Arrakis 和 Gobi 都很酷」。

并且,他在r/singularity 板块中另一个问题下, 介绍了 Arrakis 的一些能力。

他提到,「这是一个无所不能的模型,可以输入文本、图像、音频和视频的任何组合」。

具体来说,Arrakis 更多的细节包括:

- 多模态模型

- 性能远超 GPT-4

- 接近 AGI

- 幻觉发生率明显低于 GPT-4

- Altman 正试图将 Arrakis 作为一种工具来推销,尽管它是有感情的

- 推理成本略低于 GPT-4

- 非常优秀的自主智能体

- 训练一般数据是合成的

与此同时,Jimmy Apples 在社交媒体上曝出了 OpenAI 内部代号 Gobi 的项目——大规模多模态模型。

除了以上两个项目,一个代号名为「Sunshine」的项目逐渐浮出水面。

OpenAI 这些秘密进行的项目,一时间引来许多网友的猜测和讨论。

随后,FeltSteam 又爆出了更多的细节,Arrakis 据称有 125 万亿参数,大约是 GPT-4 的 100 倍,并在 2022 年 10 月完成训练。

值得一提的是,Arrakis 不是通过计算资源实现的,而是通过提高计算效率实现的。

目前,OpenAI 内部也在使用 Arrakis 进行研究,不过整体员工水平肯定优于 Arrakis。另外,与 GPT-5 相比,Gobi 更接近 GPT-4.5。

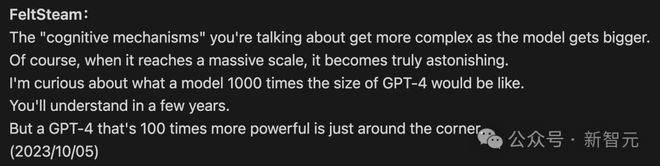

到了 10 月,FeltSteam 再一次表示,一个比 GPT-4 大 100 倍的模型即将问世。

GPT-5 将在 2024 年年中,或在 2024 年第三季度发布。

最近 BussinessInsider 的报道称,知情人士透露,GPT-5 或将在今年夏天发布。与 FeltSteam 预测的时间几乎吻合。

而 Arrakis 是 GPT-5 一个更强大的候选者,在多个领域具备人类水平的专业知识能力。

GPT-5 不是 AGI

不过,Arrakis 并不符合 Altman 对 AGI 的定义,即解决「量子引力」的问题。

量子引力,又称量子重力,是描述对重力场进行量子化的理论,属于万有理论之一隅;主要尝试结合广义相对论与量子力学,为当前物理学尚未解决的问题

但正如之前所说,Arrakis 模型还是能够达到人类专家水平。

GPT-5 和 GPT-6 都不是 AGI

FeltSteam 表示,传说中的 AGI,是 Arrakis 以外的东西。

但是,为什么我们能在这么短的时间里,训练出一个 125 万亿参数的模型呢?

理论上来说,如果训一个 1.75 万亿参数模型需要4-5 个月,那么如果训练一个大百倍的模型,应该需要几十年。

(目前已知,GPT-4 在 A100 集群上训了 100 天,但是在训练之后,OpenAI 又花了几个月时间对它微调和对齐。)

显然,要训 125 万亿参数的模型,不仅要投入原始计算资源,还要显著提高计算效率。

用 90% 合成数据训练

另一个比较值得关注的信息是,据称 Arrakis 去年训练的数据集中约 90% 是合成数据。

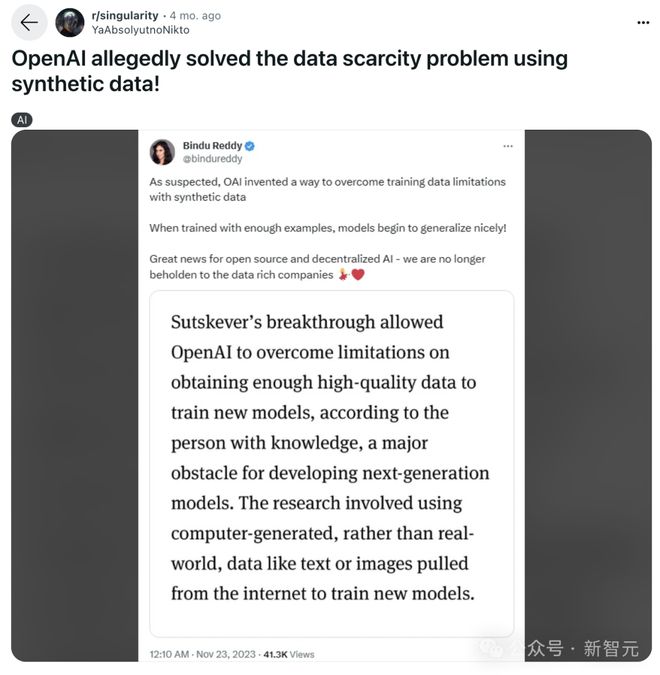

此前,外媒报道称:Ilya Sutskever 的突破让 OpenAI 克服了在获取高质量数据以训练新模型方面的限制,而这正是开发下一代模型的主要障碍。这项研究涉及使用计算机生成的数据,而不是真实世界的数据,如从互联网上提取的文本或图像来训练新模型。

FeltSteam 认为,OpenAI 正遇到了扩展(scaling)的难题,因为仅仅扩展注意力和模型参数是远远不够的。

目前,GPT-4 的训练已经穷尽了整个互联网的数据,还需要进行强化学习,甚至更多的数据。

另外,Arrakis 还是一个非常出色的自主智能体。

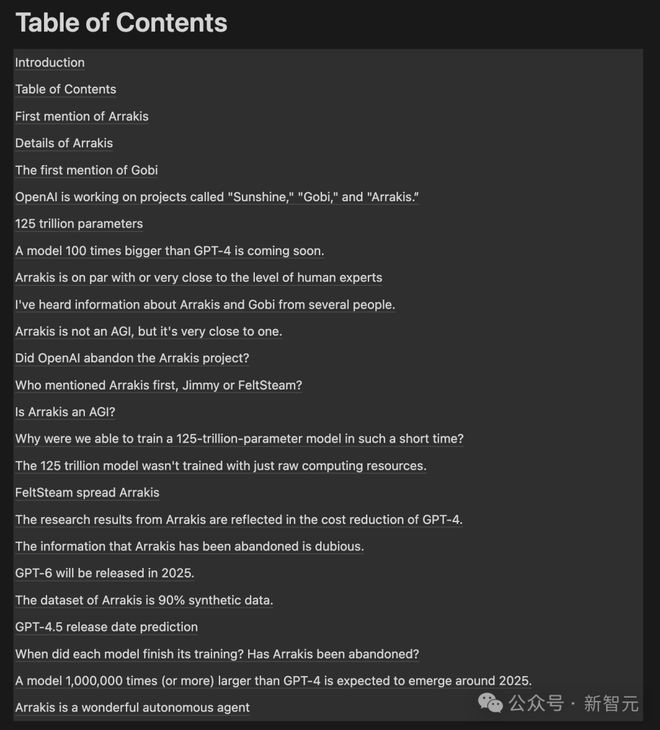

所有关于 OpenAI 项目信息汇总目录一览表。

十万个 H100 训 GPT-6,被电力卡脖子

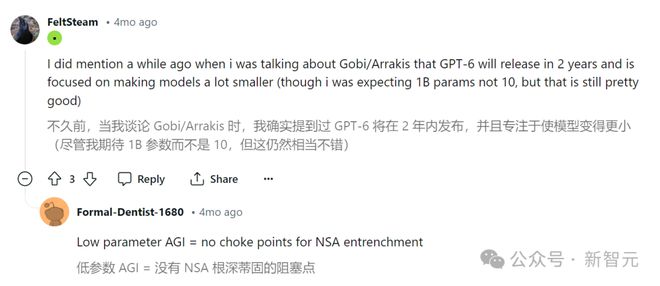

就在以上的爆料帖中,有一种说法是,GPT-6 将于 2025 年发布。

而就在爆料微软工程师对话的帖子中,也再次证实:微软正用 10 万个 H100 来帮 OpenAI 训练 GPT-6!

有网友算了一下,如果十万个 H100 同时开启,功耗将达到 70 兆瓦,电网肯定撑不住。

而熟悉电力行业的网友说,一般大型电厂的输出功率将达到 2000 兆瓦,100 兆瓦的负载其实并不大。但是突然在电网中增加 100 兆瓦的负载肯定会让电网系统出问题。

核能也许是唯一的办法了,电力短缺将直接限制未来 GPU 的发展。

此前,ChatGPT 每天耗电已超 50 万千瓦时,登上了热搜,足见 AI「吃电」非常凶猛。

根据波士顿咨询集团的分析,到 2030 年,数据中心的用电量预计将增加两倍,相当于为大约 4000 万美国家庭供电所需的电力量

没想到,马斯克预言的由 AI 导致的电力短缺,这么快就卡住 AGI 的脖子了。

马斯克:「现在 AI 对算力的需求差不多每半年就会增加 10 倍,马上会超过宇宙的质量。芯片短缺缓解后,马上就会出现电力短缺。如果电网输出 100-300 千伏的电压,然后必须一路降压至 6 伏,未来会出现变压器短缺」。

包括 Sam Altman 在内的越来越多的 AI 行业大佬表示,AI 的第一性原理,最重要的部分就是能源和智能的转化率的问题。

而人工智能是能源的无底洞,AI 未来将会被能源卡脖子。

因为 Transformer 本质上不是一个能效很高的算法,所以在未来,能源将会是困扰 AI 发展的一个大问题。

对此,网友们表示,长期看好中国基建。

而在 Altman 看来,满足 AI 飙升能源需求的最有效方法,就是核聚变。

为此,他本人就在核聚变上投资了真金白银的数亿美元。

没有突破,就没有办法到达那里,我们需要核聚变。

然而,真要达成核聚变,却没那么快。

英国曼彻斯特大学核聚变研究员 Aneeqa Khan 表示,“在地球上重建太阳中心的条件是一个巨大的挑战”,可能要到本世纪下半叶才能准备就绪。

「核聚变已经为时已晚,无法应对气候危机。在短期内,我们可利用的是现有的低碳技术,比如裂变和可再生能源」。

国际能源署(IEA)最近的一项分析计算出,数据中心、某货和人工智能的电力消耗在未来两年内可能会翻一番。2022 年,它们约占全球电力需求的2%。同时 AI 的需求将呈指数级增长,在 2023 年至 2026 年间至少增长 10 倍

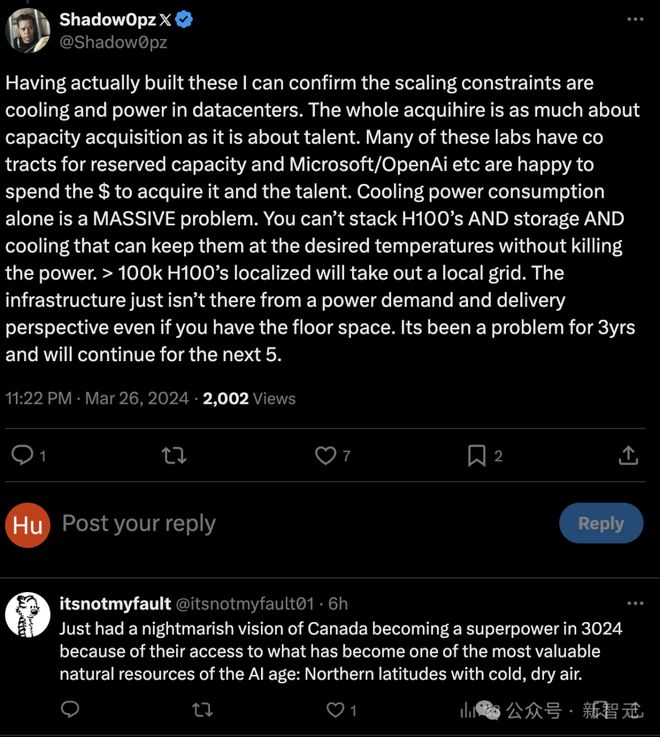

此外,除了电力的限制之外,网友还继续脑洞大开,认为散热也将成为一个问题。

10 万块 H100 还会带来散热和空间堆叠的问题,其实最近 3 年这些问题一直都存在,未来还会越来越严重。

网友进一步调侃到,未来加拿大会成为 AI 大国,因为他们有取之不尽的寒冷且干燥的空气!这些在 AI 时代将会是宝贵的自然资源。

参考资料:

https://x.com/ai_for_success/status/1772701538705617167?s=20

https://twitter.com/ai_for_success/status/1772492362872168656?t=VDn6nXceeqOAuRZYi58vgA&s=19