允中发自凹非寺

量子位公众号 QbitAI

视觉语言模型屡屡出现新突破,但 ViT 仍是图像编码器的首选网络结构。

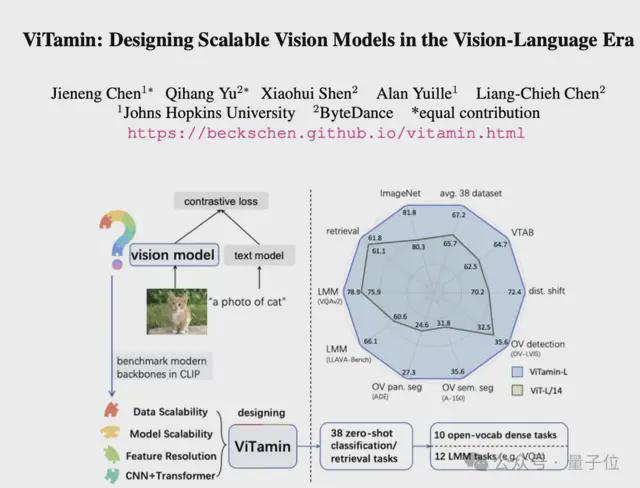

字节提出新基础模型——ViTamin,专为视觉语言时代设计。

在使用相同的数据集和训练方案时,ViTamin 在 ImageNet 零样本准确率上比 ViT 提高了 2.0%。

此外在分类、检索、开放词汇检测和分割、多模态大语言模型等 60 个不同基准上都表现出了良好的结果。

当进一步扩展参数规模时,ViTamin-XL 仅有 436M 参数,却达到了 82.9% 的 ImageNet 零样本准确率,超过了拥有十倍参数(4.4B)的 EVA-E。

最终这一成果,入选计算机视觉顶会 CVPR2024。

视觉语言时代新基准

在视觉语言时代下,如何设计一个更好可扩展的视觉模型?

在 ImageNet 时代,新的视觉模型在 ImageNet 数据集得以验证,也造就了不断有新的视觉模型涌现。但在视觉语言时代,新的视觉模型鲜为人见。

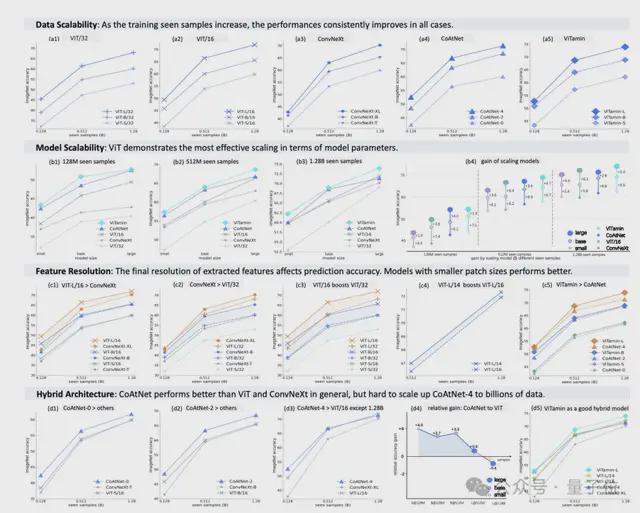

此外,基于现有常见视觉模型,在面对比 ImageNet 数据规模还大的情况下表现又是如何?研究团队们测试了几种常见模型,包括纯 Transformer 的 ViT,纯卷积网络的 ConvNeXt,以及混合卷积和 Transformer 的 CoAtNet。

最终在一个公开的数据集上进行了系统性的训练和比较,得出了一些关键发现:

第一,模型的扩展性:由于可扩展的自注意力机制,ViT 能最好地适应不同规模的任务。 第二,数据的扩展性:随着训练数据的增加,所有模型的性能都有所提升。 第三,特征的分辨率:在训练过程中,模型需要理解更广泛的信息,而不仅仅是简单的类别标签。因此,提取的特征的分辨率对模型的预测能力有很大影响。 第四,混合架构:在一般情况下,CoAtNet 表现优于其他模型,但将其扩展到处理数十亿数据可能会有一些挑战。基于这些发现,研究人员设计了ViTamin 模型。

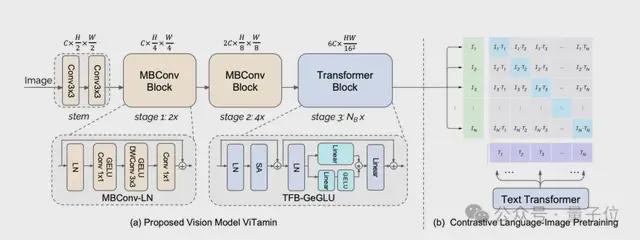

它采用了三个阶段的混合架构。前两个阶段使用了轻量级的 MBConv Blocks,第三个阶段包含了可扩展的 Transformer Blocks。

具体来说,一张图片首先经过卷积 stem 处理,得到 2 倍降采样的特征图。

然后,这个特征图经过第一阶段,由两个 MBConv-LN Blocks 组成,接着经过第二阶段,由四个 MBConv-LN Blocks 组成,然后降采样得到 16 倍降采样的二维特征。

接下来,这些特征被展平成一维,并输入到第三阶段,该阶段由N_B个 TFB-GeGLU Block 组成。最后,通过对比图像特征和语言特征,来学习对比损失函数。

作者们致力于简单有效的scaling law,只考虑模型的宽度C和模型第三阶段的深度N_B,因此在 scaling 到更大的模型中,通过模型的参数规模可以直接反推需要多大的宽度和深度,进而实现模型的 scaling。

多项 SOTA

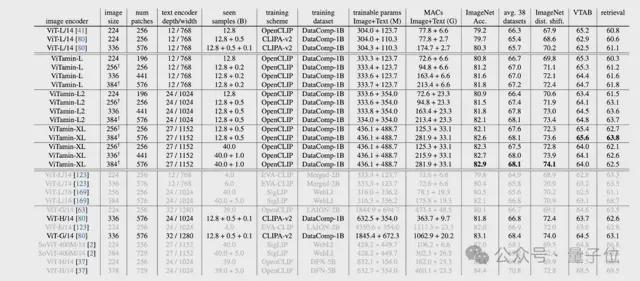

在零样本性能上面,研究结果显示,ViTamin-L 的零样本 ImageNet 准确率比 ViT-L/14 高出了 2.0%。

当将特征分辨率增加到 576 个 patch 时,ViTamin-L 的准确率进一步提高到了 81.8%,比之前的 ViT-L/14 CLIPA-v2 高出了 1.5%。在 38 个数据集的平均性能上,ViTamin-L 比 ViT-H/14 模型高出了 0.4%,而且参数数量只有 ViT-H/14 的一半。

此外,当进一步扩大模型规模时,参数量为 436M 的 ViTamin-XL 达到了 82.9% 的 ImageNet 零样本准确率,超过了 4.4B 参数量的 EVA-E 取得的 82.0%。

作者们进一步验证了ViTamin 模型对下游任务而言是个强大的视觉编码器。

作者们引入了一系列下游任务,包括开放词汇检测和分割,以及多模态大模型(LMMs)。

ViTamin 在开放词汇检测任务 OV-LVIS 上,相比比 ViT-L 模型能提高了 3.1%。ViTamin 在 8 个开放词汇分割任务中,相比 ViT-L 平均提升了 2.6%。

ViTamin 能直接迁移到多模态大模型诸如 LLaVA 上,并在 12 个多模态问答等基准上表现出色。值得注意的是,ViTamin 在 7 个开放词汇分割基准上创造了新 SOTA。

在这项工作中,作者们建立了主流视觉模型在视觉语言情境下的评估基准,并对它们进行了重新基准测试。作者们从数据可扩展性、模型可扩展性、特征分辨率和混合架构四个方面考察了主流的视觉模型。

这四个方面的关键发现为 ViTamin 的设计提供指导,ViTamin 模型不仅在零样本 ImageNet 准确率和平均 38 个数据集准确率方面全面超越 ViT,而且在包括开放词汇检测和分割以及大型多模态模型在内的 22 个下游任务上达到了最新的技术水平。

来自智能创作团队

智能创作团队是字节跳动 AI & 多媒体技术团队,覆盖了计算机视觉、音视频编辑、特效处理等技术领域。

他们借助公司丰富的业务场景、基础设施资源和技术协作氛围,实现了前沿算法 - 工程系统 - 产品全链路的闭环,旨在以多种形式为公司内部各业务提供业界前沿的内容理解、内容创作、互动体验与消费的能力和行业解决方案。

目前,智能创作团队已通过字节跳动旗下的云服务平台火山引擎向企业开放技术能力和服务。更多大模型算法相关岗位开放中。

论文链接:

https://arxiv.org/pdf/2404.02132.pdf

项目主页: